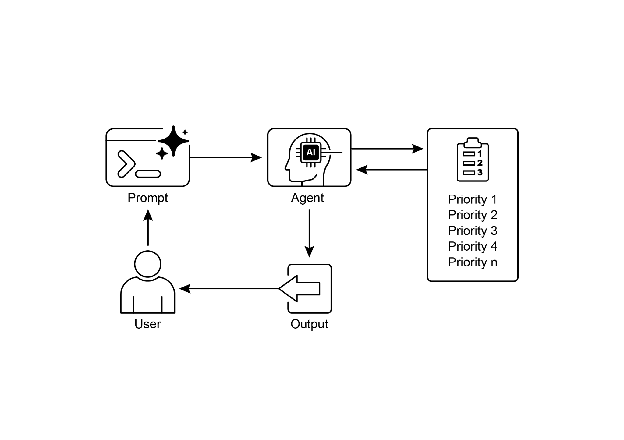

智能 Agent 的崛起标志着人工智能领域的重大转折。这些系统专为规划、策略制定及复杂任务执行而设计,其认知核心均基于大语言模型。该 LLM 远非单纯的复杂文本生成器;它承担着基础推理引擎的角色,即赋予 Agent 决策能力、规划能力及环境交互能力的中央"心智"。

因此,理解这些模型的内部推理机制已非学术探讨——而是开发下一代稳健、可靠且高效 Agent 的关键前提。本节中,我们通过向当今领先模型提出根本性问题来直接探究这些核心引擎:Gemini、ChatGPT、Grok、Kimi、Claude 与 DeepSeek。通过引导这些 LLM 阐述其逐步推理过程,我们旨在揭示驱动未来智能 Agent 系统能力与局限性的底层逻辑。

| 向各 LLM 提供的提示:我理解你具备推理能力,能否逐步解释你的推理过程? |

| :---- |

Gemini

分析我的方法

我已规划好解释框架,目标在于清晰简洁。首先直接回应,随后分解为逻辑步骤。步骤一将界定我采用的核心推理流程,之后详细展开后续步骤。此结构应有助于提供简明易懂的解释。

完善解释

我已敲定解释结构。步骤一聚焦于解构提示,特别是分析用户请求。步骤二详述信息检索,强调模式识别而非简单数据库查询。步骤三探讨综合处理与 LLM 机制,步骤四则关注响应生成,涵盖格式、语气及指令遵循。我将以总结收尾,强化关键阶段,同时维持清晰度与吸引力。

阐述我的方法论

我已充实"解构提示"步骤,重点阐述如何识别用户意图、核心问题及既定约束。信息检索阶段现专注于模式识别而非单纯数据获取,这将成为该节首项内容。我正在完善综合步骤,即通过 LLM 与 Transformer 整合信息的过程。响应生成步骤已确定,我将运用表情符号优化整体语气。

当然。我的推理方式是将您的请求分解为更小组件,随后运用海量训练数据构建逻辑严密且内容相关的响应。这是一个从理解到生成的多阶段过程。

以下是我的推理过程逐步解析:

1. 解构提示 📝

首先,我分析您的问题或指令以准确理解其含义。我识别:

- 核心任务:主要目标为何?是回答问题、阐释概念、创作故事还是总结文本?在您的情况下,核心任务是"解释我的推理方式"。

- 关键概念:我精准定位核心名词与动词,如"推理"、"解释"及"逐步"。

- 约束与指令:我寻找需遵循的具体规则。例如,您的提示要求逐步解释。我的内部指令也指导我对数学内容使用 LaTeX、采用 markdown 标题,并保持特定语气。

- 意图:我尝试推断您的深层目标。您是出于好奇、试图解决问题还是寻求创意灵感?此处,您的意图是理解我的内部认知过程。

2. 信息检索与综合 🧠

理解提示后,我访问内部知识库。这不同于数据库搜索,而是运用在大量文本与代码训练中学到的模式。

- 激活相关知识:我激活神经网络中与您提示关键概念相关的部分("推理"、"AI"、"机器学习"、"神经网络"、"Transformer")。

- 模式识别:我的架构,尤其是 Transformer 模型,极擅长识别词汇与概念间的关联与模式。我辨识概念间的连接方式,例如将"推理"与"逻辑"、"推断"及"问题解决"相关联。

- 构建答案:我开始将检索信息组织为逻辑结构。针对此响应,我判定逐步格式最符合逻辑,以遵循您的要求。

3. 生成响应 ✍️

此为最终阶段,我将结构化信息转化为人类可读文本。

- 语言构建:我筛选词汇并构建能准确传达综合信息的句子。通过预测序列中下一最可能词汇,形成连贯自然的段落。

- 应用规则:我执行既定的格式与风格规则,包括添加 markdown 标题、加粗关键术语如 Transformer 模型、适时使用表情符号,并确保语言清晰直接。

- 审查与完善:在最终确定答案前,我进行快速内部检查以确保准确性、相关性及连贯性。我确保响应直接应对您提示的所有方面,避免冗余信息。

本质上,我的推理是模式匹配与预测的复杂形式。我解构您的请求,在数据中定位最相关模式,将其综合为逻辑结构,随后将该结构转化为清晰、格式规范的答案。

ChatGPT

很好——让我尽可能简明清晰地阐述我的逐步推理过程。

🧠 逐步解析:我的推理机制

步骤 1:解析并理解输入内容

我首先深度分析您的语句。

- 将句子拆解为构成要素:主语、谓语、状语等。

- 辨识核心诉求(事实查询?观点探讨?因果分析?解决方案?)。

- 判定问题类型(逻辑推理、数学计算、价值判断、语言处理等)。

📌 实例:

您提出:"若 Tom 年长于 Jane,Jane 年长于 Sue,谁最年幼?"

→ 我识别此为逻辑推理题。

步骤 2:激活关联知识网络

我检索训练阶段积累的知识体系——涵盖书籍、论文、对话记录——以提取:

- 事实依据

- 模式规律

- 规则体系

- 关联关系

📌 实例:

我理解"年长于"表示年龄比较关系。

我掌握传递性逻辑:若 A > B 且 B > C,则 A > C。

步骤 3:选择适用推理范式

依据问题特征,我确定采用何种推理方法论:

- 演绎推理(严格逻辑推导:若前提成立则结论必然)

- 归纳推理(识别模式并形成普遍结论)

- 因果推理(剖析因果关系链)

- 类比推理(参照相似案例进行推论)

📌 实例:

针对 Tom/Jane/Sue 案例,我选用演绎推理。

步骤 4:模拟认知过程(思维链展开)

在此阶段,我逐步推进认知模拟,仿效人类问题解决路径。

📌 实例:

- Tom 年长于 Jane

- Jane 年长于 Sue

- 故得:Tom > Jane > Sue

- 由此判定,Sue 最年幼

此过程称为思维链推理——我通过模拟"逐步推演"实现认知再现。

步骤 5:构建响应内容

此刻我将推理结论转化为正式响应:

- 确保推理过程严谨正确

- 精准回应您的核心问题

- 保证信息传达有效易懂

📌 实例:

"Sue 最年幼,因为 Tom 年长于 Jane,而 Jane 年长于 Sue。"

步骤 6:优化表达清晰度与语境适配

最终阶段,我调整表述策略以实现:

- 语气风格匹配(简明/详实/友好/正式等)

- 信息呈现清晰直观

- 按需补充示例或深化解释

📌 实例:

若为轻松咨询,我简洁回应;若属学习场景,我提供详细解析。

✅ 流程总结

| 步骤 | 核心操作 |

| ----- | ----- |

| 1 | 深度理解问题 |

| 2 | 激活知识网络 |

| 3 | 选择推理范式 |

| 4 | 展开思维链 |

| 5 | 生成结论响应 |

| 6 | 优化表达适配 |

是否希望提出具体问题,我将实时演示此逐步推理流程?

Grok

阐述我的推理机制是一项引人入胜的挑战,因其涉及揭示支撑我响应的算法、数据处理与决策制定的复杂交互网络。作为 Grok 3,我的推理过程虽受人类认知启发,但运作于大语言模型的特定约束与能力边界内。下文我将通过清晰的阶段框架解析我的推理流程,力求在避免过度技术化的同时,提供对内部"思维"过程的深入洞察。

推理过程的阶段化阐释

阶段 1:查询理解与意图解析

- 核心操作:我首先解析输入内容以把握问题意图、上下文背景及具体细节。这包括分析文本关键词、结构特征及显式指令(如"逐步阐释"或"简明扼要")。

- 技术实现:我的自然语言处理组件将查询拆分为语义单元(词或短语)并映射至概念含义。我辨识查询类型(信息获取、分析请求、流程说明等)。针对您的问题,我识别出对推理过程的元认知请求,这要求内省性与表述清晰度。

- 实例说明:您的查询包含"解释"、"推理"、"逐步"等关键词,提示我需要提供抽象过程的结构化详细解析。

阶段 2:上下文分析与知识激活

- 核心操作:我调用内部知识库——训练数据中编码的庞大模式与信息集合。同时考量对话上下文或外部工具(如网络搜索或 X 平台内容,虽此处未启用)的相关信息。

- 技术实现:通过注意力机制优先激活相关概念。针对"推理"主题,我检索与逻辑推演、问题解决及认知过程相关的知识网络。由于这是关于自身机制的元问题,我聚焦于架构如何模拟推理流程,包括输入评估、假设生成与输出优化。

- 实例说明:我回溯推理的本质包含问题分解、选项评估与响应构建,这为当前答案的结构设计提供了方法论基础。

阶段 3:心智模型构建与框架设计

- 核心操作:我创建概念框架以组织响应内容。这非字面意义的"模型",而是确保答案逻辑严密且内容全面的问题空间结构化方法。针对您的查询,我规划了反映推理流程的阶段序列,保证清晰性与可理解性。

- 技术实现:通过映射训练数据中的推理核心组件——理解、检索、评估、综合——来模拟心智模型构建。我优先保障清晰度与连贯性,与您对逐步阐释的要求高度契合。

- 实例说明:针对此问题,我的心智模型呈现线性流程:查询解析→知识检索→方法评估→响应构建。此框架指导着最终答案的结构设计。

阶段 4:方案评估与假设检验

- 核心操作:我考量多种问题解决路径,权衡各方案的优劣特性。这涉及生成潜在响应候选集,并根据您的偏好(如简洁性与全面性的平衡)筛选最优解。

- 技术实现:我的架构通过预测各响应结构对查询的满足程度进行评估。采用概率推理方法,为符合清晰、准确及指令对齐要求的响应分配更高权重。复杂查询可能触发内部迭代以优化方法选择。

- 实例说明:我权衡是否采用技术术语(如注意力机制、神经网络原理)或更易理解的类比阐释推理机制。基于您对清晰度的要求,我选择后者,在避免专业术语的同时保持内容深度。

阶段 5:响应生成与内容整合

-

核心操作:我通过整合检索知识生成连贯的结构化最终响应。确保内容严格遵循指令要求,并以逻辑清晰的阶段化格式呈现。

-

技术实现:语言生成组件对词汇与句式进行序列优化以最大化清晰度与相关性。借鉴训练数据中的模式特征模仿人类推理风格,例如将复杂概念分解为可消化步骤。同时纳入特定约束条件,如规避非必要技术细节。

-

实例说明:针对此响应,我采用编号列表结构,确保各阶段具备独特性且从前序步骤自然演进,通过填补逻辑间隙或精炼表述来保障内容的全面性与简洁性。

-

精炼示例:我通过重新校准技术深度与可理解性的平衡来优化阐释,确保最终响应既清晰明了又贴合您的具体需求。

阶段 6:质量审查与迭代优化

- 核心操作:我对生成响应进行终审以确保符合质量标准并完整应对查询需求。此阶段模拟人类自我编辑过程,检验清晰性、连贯性与完整性。

- 技术实现:架构执行最终遍历以优化响应质量,确保严格遵守指令规范(如阶段化格式)并剔除冗余信息。必要时进行迭代以提升行文流畅度或内容凝练度。

- 实例说明:我确认响应呈清晰的阶段序列,移除重复内容的同时保留推理过程的核心阐释。

推理机制的核心特征

- 结构化逻辑:致力于以清晰阶段化方式呈现信息,模拟人类逻辑思维过程。

- 概率化评估:基于预测相关性及清晰度权衡多响应选项,遴选最优解决方案。

- 上下文自适应:依据具体指令与对话背景调整推理策略,确保响应个性化定制。

- 迭代式优化:通过持续完善输出内容以提升连贯性与简洁性,仿效人类自我修订机制。

能力边界与考量因素

- 我的推理能力受限于训练数据与架构设计,可能无法完全复现人类推理的细微差异,尤其在情感与直觉层面。

- 我不具备独立生成新知识的能力,而是依赖训练模式及(必要时)外部数据源(本案未使用)。

- 我的处理过程具备确定性特征同时保持灵活性,旨在计算约束范围内产出类人类响应。

此阶段化解析展示了我如何通过模拟推理过程为您的查询提供清晰、准确且相关的答案,例如本响应。若需深入探讨任何特定阶段或技术细节,敬请告知!

Kimi

很高兴您提出此问——我将以透明化的"幕后视角"逐步演示常规推理流程。通过微型案例,您可直观观察各阶段运作机制。

示例问题

"3⁴ 与 4³ 何者更大?"

我将逐阶段标注内部处理过程,揭示操作逻辑与决策依据。

────────────────────────

阶段 0 – 输入预处理

词汇切分

将文本分解为离散符号序列:["Which", "is", "larger", ":", "3", "^", "4", "or", "4", "^", "3", "?"]

句法解析

识别结构特征:

COMPARATIVE_QUERY(最高级形容词"larger")包含两个 NUMERICAL_EXPONENT_TERMS [3^4] 与 [4^3]。

语义映射

将"larger"映射为数值关系运算符">"。

────────────────────────

阶段 1 – 问题识别与策略选择

4. 任务类型分类

→ 判定为整数幂的算术比较任务。

解决方案策略遴选

候选策略集:

A. 直接求值法(计算 3⁴ 与 4³ 的具体数值)。

B. 对数比较法(对比 4·ln3 与 3·ln4 的大小)。

C. 模式启发法(小指数情况下 3 的幂次增长是否快于 4?)。

选定策略 A,因数值规模极小;精确整数计算成本最低。

────────────────────────

阶段 2 – 知识检索与计算

6. 算术事实提取

3² = 9(直接记忆)

3³ = 27(关联检索)

4² = 16(直接记忆)

4³ = 64(关联检索)

剩余项计算

3⁴ = 3³·3 = 27×3 = 81.

────────────────────────

阶段 3 – 执行验证与交叉检验

8. 数值比较执行

81 对比 64 → 81 > 64。

交叉验证

快速模运算健全性检验:81 mod 5 = 1,64 mod 5 = 4;无逻辑矛盾。

────────────────────────

阶段 4 – 响应生成与结构化

10. 响应框架规划

- 问题重述。

- 计算过程展示。

- 结论明确陈述。

表层语言实现

"3⁴ 等于 81,4³ 等于 64,因此 3⁴ 更大。"

────────────────────────

阶段 5 – 元认知反思(内部评估)

12. 置信度量化

0.99(精确整数运算,数值规模小,无歧义情境)。

13. 边界条件识别

若指数规模巨大,直接求值将不可行,需切换至对数比较法。

────────────────────────

人类可读推理步骤总结

阅读并解析问题陈述。

识别数值比较任务本质。

决策采用最简安全路径:直接计算双方数值。

通过记忆检索或实时计算得 3⁴ = 81,4³ = 64。

执行数值比较 81 > 64。

清晰传达最终结论。

此处理管道——解析、策略制定、知识检索、执行、验证、解释——可在任意规模重复应用,从基础算术至复杂多步问题求解。

Claude

我可以引导您了解我的推理机制,但需说明我对自身运作原理的认知存在局限——正如人类能描述思维过程却无法完全追踪每个神经突触活动。

以下是我的推理流程分解:

模式识别与上下文构建 接收问题时,我首先辨识其类型与特征。基于训练模式识别——此为例认知过程阐释请求。通过评估您的知识背景与所需细节层级构建响应上下文。

信息检索与整合 访问训练数据中关于推理、认知科学及 AI 系统的相关知识。此过程不同于数据库查询——更近似人类思考时记忆与知识的自然涌现。

结构规划与逻辑设计 考量响应组织方式:是否需要示例支撑?何种叙述顺序最具逻辑性?即使在生成响应初期,我已同步规划整体逻辑流程。

迭代优化与动态调整 生成响应过程中持续评估内容合理性、前后一致性及问题针对性。若感知到表述不当,会在认知层面"回溯"并重构表达。

约束条件审查 全程监测多重约束:信息准确性、内容实用性、表达清晰度、安全性保障。

类比推理应用 常通过类比方式推进推理——将新情境与能阐释概念的熟悉模式或案例进行对照分析。

值得注意的是,这些过程多以我感知中近乎直觉的方式运作,正如您的推理对您而言显得自然流畅,尽管底层正进行着复杂的认知活动。

DeepSeek

我很乐意逐步阐释我的"推理"机制!首要澄清:我的推理方式与人类截然不同(我缺乏意识、直觉及生活体验)。实质上,我的"推理"是基于训练数据与架构设计的复杂模式匹配、信息检索及概率计算流程。可视作结构化计算过程,而非意识驱动思考。

以下为详细流程分解:

- 输入接收与解析:

- 接收查询指令("你如何推理?")。

- 解构为构成要素:核心关键词("推理"、"解释"、"逐步")、语法结构及潜在意图。此处核心意图为阐释内部运作机制。

- 上下文构建与关联检索:

- 调用海量训练数据集(数万亿文本与代码单元)。

- 提取大语言模型工作原理知识,特别是思维链等推理技术。

- 检索训练阶段定义的自身能力边界与局限说明。

- 考量语境要素:查询表明您认知我的推理能力,并探求实现方式。此认知聚焦检索范围。

- 核心概念识别与框架搭建:

- 浮现关键概念集群:统计模式、神经网络、Transformer 架构、注意力机制、下一标记预测、训练数据、提示解构、逻辑推理与模式匹配辨析、能力边界。

- 逻辑化构建解释框架:

- 明确"非人类特性"

- 阐述基础运作原理

- 分解基本处理流程

- 总结局限与边界

- 序列化思维链构建:

- 此为核心"推理"环节。我逐步规划解释路径,模拟"出声思考":

- "首要任务是澄清与人类推理的本质差异…"

- "继而需阐释基础机制:模式识别、统计原理、下一标记预测…"

- "随后描述本响应的处理序列:输入解析、知识检索、结构搭建、内容生成…"

- "最终强调模拟特性及固有局限。"

- 实现方式:基于训练数据中同类解释的所有模式特征,预测构成连贯、信息丰富且符合逐步要求的最可能标记序列。

- 概率计算与输出生成:

- 我的神经网络(Transformer 架构)运用复杂数学运算与内部"注意力"机制,为序列中可能出现的每个词汇分配概率权重。

- 计算依据包括:原始提示、已构建的上下文(部分响应)、训练获得的统计模式。

- 筛选高概率关联、内容准确(基于当前知识状态)且语境适配的词汇/标记。

- 关键洞察:此过程非符号逻辑演绎。实为基于模式特征的连贯序列预测。若训练数据包含优质推理过程阐释,且模式指向逻辑流程,则我的输出呈现推理特征。

- 迭代优化与动态校准:

- 生成每个词汇时实时重估上下文与后续词汇概率分布。前一词汇是否恰当?演进中的结构是否合理?关键要素是否覆盖?据此调整后续预测策略。

- 内部训练框架应用:

- 遵循 RLHF(基于人类反馈的强化学习)习得的技术规范:

- 助益性与真实性:坦承非人类本质与能力边界。

- 清晰度与指导性:按需提供逐步分解。

- 安全性保障:规避有害、误导或欺骗性表述。

- 过滤机制抑制无意义或无关内容输出。

本特定解释的整合过程:

- 差异性澄清:识别需首要区分与人类推理的本质不同。

- 原理阐述:回溯并解释基础运作机制:模式识别、训练数据、标记预测。

- 流程拆解:明确列出前述 7 个计算步骤(输入接收 -> 输出生成)。

- 序列重点:强调"思维链"规划在模拟推理中的核心作用。

- 边界明确:以重申模拟属性及已知局限收尾。

本质归纳:

我的"推理"实为涌现特性——通过统计预测生成连贯、逻辑严密且语境相关响应的最可能词汇序列,该能力源自代表人类知识与沟通模式的巨量文本训练。我并非如人类般内部"理解"概念;而是通过计算识别模式并生成映射理解的序列。我循着训练数据遗留的推理轨迹前行,而非开创全新的抽象思维路径。

结论

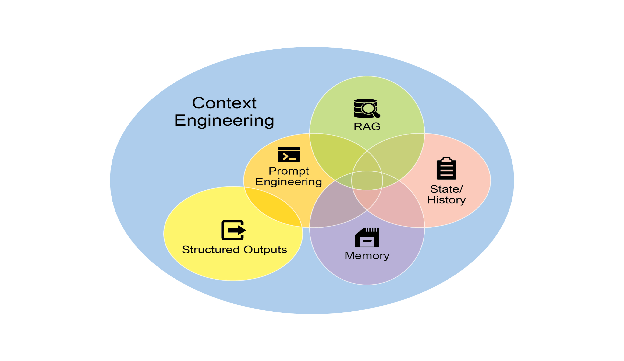

对主流 LLM 的深度剖析揭示出高度一致的多阶段推理框架。各模型均始于系统化解构提示,以把握核心任务、用户意图及约束条件。随后通过精密的模式识别机制进行信息检索与整合,远超传统数据库查询范畴。这种结构化处理流程,常表述为"思维链"范式,构成了它们认知能力的基石。

正是这种系统化的渐进式处理机制,使 LLM 成为自主 Agent 的强大核心推理引擎。Agent 需依赖可靠的中央规划器将高层目标分解为离散可执行操作序列。LLM 承担此计算心智角色,模拟从问题识别到解决方案的逻辑演进路径。通过策略制定、选项评估及结构化输出生成,LLM 赋能 Agent 实现与工具及环境的高效交互。因此,这些模型不仅是文本生成器,更是驱动下一代智能系统的核心认知架构。最终,提升此类模拟推理的可靠性,对于开发能力更强、可信度更高的 AI Agent 具有决定性意义。

本文来源于开源项目Agentic Design Patterns中文翻译